I tecnici dell’Unione Europea hanno finalizzato l’AI Act, la prima legislazione che regolamenta la tanto discussa intelligenza artificiale (IA) che ha raggiunto la versione finale.

Dopo la maratona di tre giorni di negoziati dello scorso dicembre da parte del trilogo composto da Commissione Europea, Consiglio e Parlamento, i tecnici dell’Unione Europea hanno lavorato a lungo per raggiungere il testo ora finalizzato dell’AI Act che è ora approvato da tutti i 27 Stati Membri dell’UE. Dovremo attendere l’approvazione ufficiale da parte del Parlamento dell’Unione Europea del primo regolamento al mondo sull’intelligenza artificiale, che probabilmente avverrà nell’aprile 2024, ma sembra essere una mera formalità.

La definizione di sistema di intelligenza artificiale secondo l’AI Act finalizzato

Esiste una nuova definizione di sistema di intelligenza artificiale che differisce leggermente da quella fornita dalle linee guida dell’OCSE ed è la seguente:

sistema basato su una macchina progettato per operare con vari livelli di autonomia e che può mostrare capacità di adattamento dopo l’implementazione e che, per obiettivi espliciti o impliciti, deduce, dagli input che riceve, come generare output come previsioni, contenuti, raccomandazioni o decisioni che possono influenzare ambienti fisici o virtuali.

Le tre componenti principali della definizione sono che copre

- sia i sistemi in cui l’AI opera in piena autonomia, sia quelli con input umani;

- i sistemi che possono adattarsi come conseguenza delle informazioni che vengono loro fornite e

- i sistemi che, in base alle informazioni ricevute, imparano a generare output.

L’obiettivo del legislatore europeo è quello di adottare una definizione di sistemi di AI che sia la più ampia possibile. Le conferisce un ampio campo di applicazione, poiché l’intelligenza artificiale potrebbe avere un impatto su ogni settore, escludendo dalla sua applicazione alcuni sistemi già soggetti alla legislazione di armonizzazione, nonché quelli utilizzati esclusivamente per scopi militari, di difesa o di sicurezza nazionale, oltre ai sistemi utilizzati per la ricerca scientifica, lo sviluppo e l’uso puramente personale non professionale.

Un’ulteriore eccezione molto discussa all’applicabilità dell’AI Act opera in relazione ai sistemi di intelligenza artificiale che sfruttano software gratuito e open source. Ma l’ambito dell’eccezione è così ristretto che si applicherà solo all’uso personale dell’intelligenza artificiale. Infatti, l’esenzione non si applicherà

- se il sistema di intelligenza artificiale è (i) destinato a un caso d’uso ad alto rischio, (ii) rientra negli usi proibiti o (iii) è un caso d’uso con obblighi di trasparenza; e

- se il sistema di intelligenza artificiale viene “immesso sul mercato”.

In ogni caso, le esenzioni per i software gratuiti e open source non si applicano se il sistema di IA è designato come general purpose AI (GPAI) con rischi sistemici.

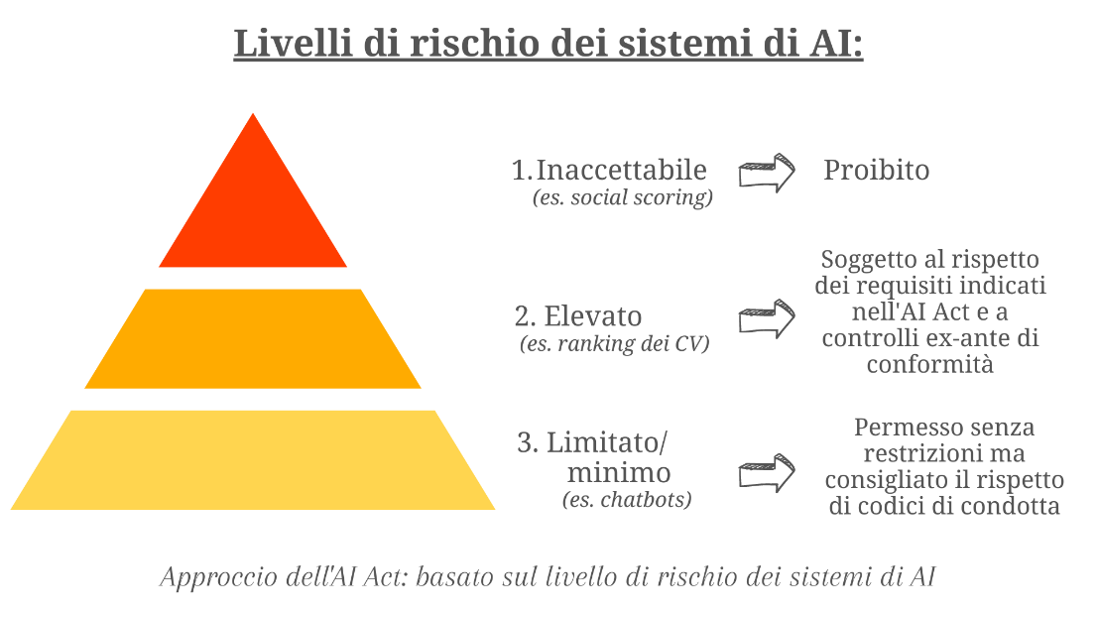

La classificazione dei sistemi di AI

Il quadro giuridico per l’AI è caratterizzato da un doppio regime che distingue tra sistemi di AI a rischio limitato e sistemi ad alto rischio. La definizione di rischio è “la combinazione della probabilità che si verifichi un danno e la gravità di tale danno” e, sulla base di tale definizione, esiste una distinzione tra

1. Sistemi di intelligenza artificiale vietati: Questi sistemi includono (i) tecniche che manipolano la cognizione e il comportamento individuale, (ii) la raccolta casuale di dati di riconoscimento facciale da Internet o attraverso le telecamere a circuito chiuso, (iii) l’uso di sistemi di riconoscimento delle emozioni nei luoghi di lavoro e nei contesti educativi, (iv) l’impiego di punteggi di credito sociale e (v) l’elaborazione biometrica per l’inferenza di dati personali sensibili come l’orientamento sessuale o le credenze religiose 📌 Tali sistemi di AI sono semplicemente vietati.

2. Sistemi di AI ad alto rischio: Questi sistemi includono (i) i sistemi di AI destinati ad essere utilizzati come componente di sicurezza di un prodotto, (ii) i sistemi di AI che rientrano nella legislazione armonizzata elencata nell’Allegato II dell’AI Act, e (iii) alcuni sistemi di AI utilizzati nel settore dell’istruzione, nei processi di recruiting, nonché per scopi di credit scoring, a meno che non vi sia uno scopo di rilevamento delle frodi, e di valutazione del rischio e dei prezzi relativi alle persone fisiche nel caso di assicurazioni sulla vita e sulla salute e per i sistemi di AI utilizzati per altri scopi elencati nell’Allegato III dell’AI Act. Tali categorie non sono tuttavia rigide, in quanto il fornitore può dimostrare che il sistema specifico non è ad alto rischio a causa delle sue peculiarità 📌 In relazione ai sistemi di AI ad alto rischio, deve essere stabilito, implementato, documentato e mantenuto un sistema di gestione del rischio per identificare i rischi e adottare azioni di mitigazione durante l’intero ciclo di vita del sistema di AI, eseguendo anche test per comprendere il funzionamento del sistema in condizioni reali. Se il sistema di AI ad alto rischio prevede l’addestramento dei modelli con i dati, dovrà essere sviluppato sulla base di set di dati di addestramento, convalida e test soggetti ad appropriate pratiche di gestione e governance dei dati elencate nell’AI Act. L’esecuzione di queste attività in relazione ai sistemi di intelligenza artificiale ad alto rischio dovrà essere dimostrata attraverso la documentazione tecnica da predisporre prima dell’immissione del sistema sul mercato o della sua messa in servizio e dovrà essere mantenuta aggiornata. Tale documentazione tecnica dovrà contenere almeno le informazioni di cui all’Allegato IV dell’AI Act. Si tratta comunque di un’autovalutazione, senza alcun riferimento a una valutazione di terzi. Tale valutazione dovrà essere supportata anche da prove ottenute attraverso la registrazione automatica di eventi (‘log’) durante la vita del sistema, che il sistema dovrà tecnicamente consentire. I sistemi di intelligenza artificiale ad alto rischio dovranno essere progettati e sviluppati in modo da

-

- garantire che il loro funzionamento sia sufficientemente trasparente da consentire agli utenti di interpretare i risultati del sistema e di utilizzarli in modo appropriato, anche grazie alle istruzioni che accompagneranno il sistema;

- consentire una supervisione efficace da parte di persone fisiche durante il periodo in cui il sistema di IA è in uso, anche con strumenti di interfaccia uomo-macchina appropriati;

- raggiungere un livello adeguato di accuratezza, robustezza e cybersicurezza, e funzionare in modo coerente sotto questi aspetti durante il loro ciclo di vita;

- essere in grado di fornire alle persone, in caso di decisioni automatizzate, una spiegazione della procedura decisionale e degli elementi principali della decisione presa;

3. Sistemi di Intelligenza Artificiale per Scopi Generali (General Purpose AI): questi sistemi “si basano su un modello di Intelligenza Artificiale per scopi generali, che ha la capacità di servire una varietà di scopi, sia per l’uso diretto che per l’integrazione in altri sistemi di Intelligenza Artificiale” e sono destinati a portare un rischio sistemico (ossia, un rischio con effetti negativi sulla salute pubblica, la sicurezza, la pubblica sicurezza, i diritti fondamentali o la società nel suo complesso, che può essere propagato su scala attraverso la catena del valore), quando sono identificati come tali dalla Commissione UE o quando la quantità cumulativa di calcolo utilizzata per la sua formazione, misurata in operazioni in virgola mobile (FLOP), è superiore a 10^25 📌 I sistemi GPAI che generano un rischio sistemico devono essere notificati alla Commissione UE. Inoltre, i fornitori di sistemi GPAI dovranno:

- redigere e mantenere aggiornata la documentazione tecnica del modello e mettere a disposizione informazioni e documentazione ai fornitori di sistemi di AI che intendono integrare il modello di AI generale nel loro sistema di AI. Tale documentazione tecnica dovrà essere redatta elencando, tra l’altro, le modalità seguite per sviluppare il sistema, le attività svolte e il consumo energetico stimato, e – nel caso di sistemi GPAI che comportano un potenziale rischio sistemico – le strategie di valutazione seguite e i test avversariali (ad esempio, il red teaming) effettuati;

- Attuare una policy di rispetto della legge sul diritto d’autore dell’Unione e redigere e rendere disponibile al pubblico un riassunto sufficientemente dettagliato dei contenuti utilizzati per l’addestramento del modello di intelligenza artificiale generale, secondo un modello fornito dall’AI Office; e

- in caso di GPAI con rischio sistemico, (i) eseguire la valutazione del modello, (ii) valutare e mitigare i possibili rischi sistemici a livello di Unione, (iii) tenere traccia, documentare e riferire le informazioni pertinenti sugli incidenti gravi e le possibili misure correttive per affrontarli e (iv) garantire un livello adeguato di protezione della cybersecurity.

4. Sistemi AI di base: Tutti i sistemi di IA, a prescindere dal livello di rischio, sono soggetti a obblighi minimi 📌 Sono soggetti a obblighi di trasparenza di base per garantire un livello minimo di chiarezza e comprensione a tutti, informando le persone che stanno interagendo con un sistema di AI.

Quali sono i soggetti obbligati ai sensi dell’AI Act finalizzato?

L’AI Act finalizzato ha un effetto transnazionale, in quanto si applica a

- fornitori (provider) che immettono sul mercato o mettono in servizio sistemi di AI o che immettono sul mercato modelli di AI di uso generale nell’Unione, indipendentemente dal fatto che tali fornitori siano stabiliti o situati nell’Unione o in un Paese terzo;

- utilizzatori (deployers) di sistemi di AI che hanno la loro sede o che sono situati all’interno dell’Unione;

- fornitori ed utilizzatori di sistemi di AI con sede o ubicati in un Paese terzo, dove l’output prodotto dal sistema viene utilizzato nell’Unione;

- Importatori e distributori di sistemi di IA;

- Produttori di prodotti che immettono sul mercato o mettono in servizio un sistema di IA insieme al loro prodotto e con il loro nome o marchio;

- Rappresentanti autorizzati di fornitori che non sono stabiliti nell’Unione; e

- Persone interessate che si trovano nell’Unione Europea.

Le definizioni più rilevanti delle categorie di soggetti di cui sopra sono quelle di

- “fornitore” (provider) che è una “persona fisica o giuridica, un’autorità pubblica, un’agenzia o un altro organismo che sviluppa un sistema di IA o un modello di IA per scopi generali o che fa sviluppare un sistema di IA o un modello di IA per scopi generali e li immette sul mercato o mette in servizio il sistema con il proprio nome o marchio, a pagamento o gratuitamente“. Il fornitore è l’entità giuridica soggetta agli obblighi più rilevanti ai sensi dell’AI Act, poiché, tra l’altro, deve garantire che i propri sistemi di AI ad alto rischio siano conformi ai requisiti della legge, anche

- avere un sistema di gestione della qualità, conservare la documentazione per poter dimostrare la conformità con il sistema di AI,

- adottare le azioni correttive se il sistema AI non è conforme all’AI Act,

- redigere una dichiarazione di conformità UE scritta a lettura ottica, fisica o firmata elettronicamente per ogni sistema di IA ad alto rischio; e

- registrare i sistemi di IA ad alto rischio nel database dell’UE rispettare gli obblighi applicabili ai sistemi GPAI

e

- “utilizzatore” (deployer) che è “qualsiasi persona fisica o giuridica, autorità pubblica, agenzia o altro organismo che utilizza un sistema di IA sotto la sua autorità, ad eccezione del caso in cui il sistema di IA sia utilizzato nel corso di un’attività personale non professionale“, che include qualsiasi azienda che riceve un sistema di AI da un fornitore per gestire le proprie attività. Per evitare qualsiasi mancanza di responsabilità da parte degli implementatori, la Legge sull’AI stabilisce che essi non solo devono

- adottare misure tecniche e organizzative adeguate per garantire l’utilizzo dei sistemi in conformità alle istruzioni d’uso che li accompagnano;

- assegnare la supervisione umana a persone fisiche che abbiano la competenza, la formazione e l’autorità necessarie, nonché il supporto necessario;

- monitorare il funzionamento del sistema di AI; e

- rispettare gli obblighi di informazione prima della messa in funzione del sistema di IA ed eseguire una DPIA quando richiesto dal tipo di trattamento dei dati personali.

Inoltre, gli implementatori di sistemi di IA ad alto rischio che, tra l’altro, sono utilizzati per il credit scoring, nonché per la valutazione del rischio e la determinazione dei prezzi in relazione alle persone fisiche nel caso dell’assicurazione sulla vita e sulla salute, devono eseguire la valutazione d’impatto sui diritti fondamentali, sulla quale può leggere l’articolo “AI Act: Valutazione di Impatto sui Diritti Fondamentali (FRIA)“. Questo obbligo è rilevante anche perché l’esecuzione della FRIA deve essere notificata all’autorità di vigilanza del mercato con i risultati della valutazione, presentando il relativo modello compilato di cui alla Legge.

Governance centrale e locale dell’AI

In termini di governance e conformità, l’AI Act finalizzato istituisce un Ufficio europeo per l’AI per monitorare i modelli di AI più complessi. Prevede la creazione di un panel scientifico e di un forum consultivo per integrare le prospettive delle diverse parti interessate. Ciò garantisce che la normativa sia sempre informata e aggiornata rispetto agli sviluppi del settore.

Ma un argomento di notevole discussione sarà quello di quali poteri in concreto saranno conferiti alle autorità locali per l’AI e quali enti saranno nominati come autorità nazionali. Come è successo con il GDPR, le autorità locali non vorranno rinunciare ai loro poteri. L’Ufficio AI dovrebbe ridurre il rischio di approcci incoerenti in tutta l’UE tra le autorità locali, ma non si possono escludere attriti politici tra le diverse autorità locali.

Le potenziali sanzioni basate sul fatturato

L’AI Act finalizzato stabilisce anche, ovviamente, un sistema di sanzioni che, come nel caso di diverse recenti normative europee, si basa sul fatturato globale delle aziende o su un importo predeterminato, a seconda di quale sia più alto. Le sanzioni saranno fino a 35 milioni di euro o al 7% per le violazioni delle applicazioni AI vietate, fino a 15 milioni di euro o al 3% per le violazioni degli obblighi dell’AI Act e fino a 7,5 milioni di euro o all’1% per la fornitura di informazioni non corrette, che possono essere emesse dalla cosiddetta ‘autorità di sorveglianza del mercato’, che è l’autorità designata da ogni Stato membro dell’UE per monitorare la conformità.

Sono previste eccezioni per le aziende più piccole, con sanzioni limitate per le PMI e le startup. Quindi, anche per quanto riguarda le sanzioni, è stato trovato un equilibrio tra la necessità di regolamentare l’AI e l’obiettivo di non limitare lo sviluppo di questa tecnologia nell’UE. Per lo stesso motivo, sono previste le cosiddette soluzioni di ‘sandboxing’, dove le soluzioni possono essere testate beneficiando di un regime speciale.

La tempistica dell’AI Act

La data di applicazione dell’AI Act finalizzata seguirà un calendario preciso, con un periodo di transizione di sei mesi per l’introduzione dei divieti, un anno per i sistemi GPAI e due anni per le restanti disposizioni, fatta eccezione per le disposizioni applicabili a dispositivi che già sono regolati da altre normative di armonizzazione comunitaria per le quali il termine è di 36 mesi.

Il testo finale sarà pubblicato sulla Gazzetta Ufficiale dell’Unione Europea entro aprile 2024, momento in cui inizieranno a decorrere le scadenze di cui sopra. Tuttavia, non c’è dubbio che, indipendentemente dalla durata del periodo di transizione, nessuna azienda sarà disposta ad adottare soluzioni di IA non conformi alla Legge sull’IA che la costringerebbe a disinvestire dalla tecnologia in tempi brevi.

Abbiamo costruito una soluzione innovativa per supportare le aziende a garantire la conformità dell’intelligenza artificiale in modo economico ed efficiente; può leggere di più QUI e contattarci per avere maggiori informazioni.

Inoltre, è disponibile QUI la registrazione di un webinar che abbiamo tenuto con i colleghi di DLA Piper sulla versione finalizzata dell’AI Act.